有一台上古小主机,想把DeepSeek部署到本地,然后通过CherryStudio远程访问。

安装Ollama

- 下载ollama安装包,并解压到本地。

https://ollama.com/download - 安装ollama。

windows 下双击下载的

olamaSetup.exe安装包安装。其他平台请参照安装文档进行安装。 在这里需要注意的是,Windows下默认会安装到C盘的users目录下,如果安装到其他目录,可以采用OllamaSetup.exe /DIR="d:\some\location"这种方式来更换安装路径。 同样的,模型默认也会下载到用户目录下,如果需要修改模型下载路径,可以在系统参数中添加一项OLLAMA_MODELS来配置模型存放地址。 - 启动ollama。

安装成功后,ollama会自动启动,可以通过

ollama list命令来查看当前安装的模型。 一开始安装模型都是空的,所以需要下载模型。

ollama run deepseek-r1:7b

模型下载需要一段时间,所以需要耐心等待。成功后直接进入交互界面,可以进行交互。 - 配置ollama远程访问。

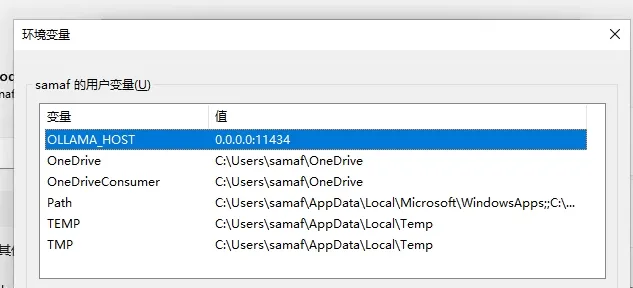

ollama默认是本地访问,如果需要远程访问,需要在环境变量中添加本地参数

OLLAMA_HOST来配置远程访问地址。 需要注意的是配置了环境变量,需要重启下电脑,否则不生效。

需要注意的是配置了环境变量,需要重启下电脑,否则不生效。

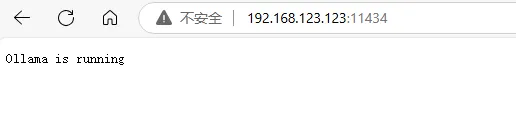

电脑重启后,应该就可以远程访问了。

测试方式:浏览器访问http://你的远程主机:11434,应该可以看到一个Ollama is running的页面。

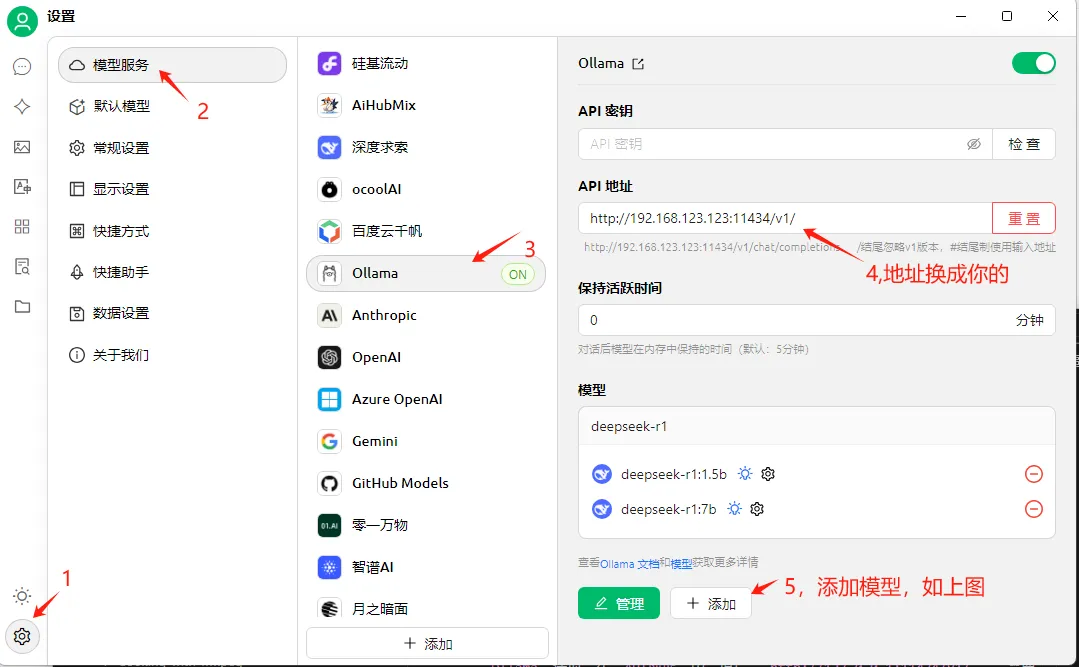

配置cherry studio远程访问

cherry studio 是一款为创造者而生的 AI 助手,里面可以配置众多AI服务商的API,来访问AI模型。

打开cherry studio软件后,点击左下角的设置图标,选择模型服务,里面有Ollama选项,在API地址中,填写http://127.0.0.1:11434/v1/,需要注意的是,你需要把127.0.0.1替换为你的ollama服务器的IP地址。

然后再返回cherry studio的主页,点击聊天图标,应该就可以直接用了。

至此,应该就可以成功使用了。

至此,应该就可以成功使用了。